读万卷书,大模型「看」懂视觉世界?Meta揭秘LLM视觉先验的起源

一个只见过文本的读万卷书大语言模型(LLM),在从未直接看过图像的大模懂视的起情况下,竟然能学到可迁移到视觉任务的型看先验安顺市某某商务咨询客服中心先验能力 —— 这是 Meta Superintelligence Labs 与牛津团队新论文的发现。

近日,觉世界Ma揭Meta 超级智能实验室(Meta Superintelligence Labs)与牛津大学的视觉研究者发布了一篇长达 33 页的重磅论文,通过超过 100 组受控实验、读万卷书耗费 50 万 GPU 小时的大模懂视的起庞大研究,系统性地揭开了 LLM 视觉先验的型看先验来源。 作者提出,觉世界Ma揭视觉先验可分为「推理先验」和「感知先验」,视觉并给出了一套预训练的读万卷书数据混合配方,用于在只用文本预训练阶段就「播下」视觉能力的大模懂视的起种子。

这项研究不仅解释了 LLM 无师自通学会看的型看先验秘密,更提出了一套预训练的觉世界Ma揭数据配方,旨在从语言预训练阶段就有意地培养模型的视觉安顺市某某商务咨询客服中心视觉能力,为下一代更强大的多模态大模型铺平道路。

- 论文标题:Learning to See Before Seeing: Demystifying LLM Visual Priors from Language Pre-training

- 论文链接:https://arxiv.org/pdf/2509.26625

- 项目地址:

- https://junlinhan.github.io/projects/lsbs/

核心洞察:LLM 视觉先验并非铁板一块,源于两种独立的「先验知识」

研究最重要的发现是,LLM 从语言中获得的「视觉先验」(Visual Priors)并非单一的能力,而是可以分解为两种来源和特性截然不同的部分:

- 推理先验 (Reasoning Prior):一种更抽象、跨模态的通用能力。它主要通过预训练以推理为中心的数据(如代码、数学、学术论文)来获得。就像人类通过学习逻辑和数学来构建推理框架一样,LLM 通过学习这些结构化文本,掌握了可迁移的、普适的推理能力,这种能力可以直接应用于解决复杂的视觉问题。

- 感知先验 (Perception Prior):这更侧重于对具体视觉概念的认知,比如识别物体的颜色、形状和名称。这种能力并非来自某一特定类型的数据,而是从广泛、多样的通用语料(如网页抓取)中「弥散式」地浮现出来。多模态大模型的感知能力对视觉指令微调和所选用的视觉编码器更为敏感。

关键发现:少量视觉描述就够,海量推理数据是关键

大量实验:系统性揭秘 LLM 的视觉先验

团队进行了一系列精巧的实验,实验采用常见的 adapter-style 多模态适配流程 —— 先在只读文本的基础上预训练多种解码器式 LLM(沿用 Llama-3 风格架构,模型尺度从 340M 到 13B 不等,核心对比以 3B/7B 模型 为主),然后用同样的「视觉对齐 + 监督微调」的两阶段流程把视觉能力接入来衡量视觉先验,得出了 6 个结论并引入 3 个假设,这里节选:

- 能力的起源有迹可循:通过对 16 种不同单一数据源的独立训练,研究发现,在「代码」「数学」和「学术」数据上训练的模型,在需要抽象推理的视觉任务(Vision-Centric VQA)上表现最好。

- 推理数据多多益善,视觉数据很快饱和:实验表明,在预训练数据中,不断增加推理密集型文本(如代码)的比例,模型的下游视觉推理能力会持续、显著地提升,直到占比达到 75% 左右。与此形成鲜明对比的是,描述视觉世界的文本(如描述颜色、形状、位置的文字)虽然重要,但其效果会迅速饱和。只需一小部分这类数据为模型打下基础,再多就收效甚微了。

- 推理能力是通用的,感知能力更依赖「后天」:研究进一步证实,「推理先验」是独立于视觉编码器的通用能力。无论后期与哪种视觉模块结合,只要 LLM 在预训练阶段学到了强大的推理能力,其多模态系统的推理表现都会相应提升。而「感知先验」则不同,它更依赖于后期的视觉微调数据和视觉编码器本身的特性。

简单来说,想要让一个 LLM 拥有强大的视觉潜力,关键不是给它读无数遍「天空是蓝色的」,而是让它通过解数学题、读代码来把「脑子」练聪明。

从理论到实践:一份增强视觉先验的数据预训练配方

基于以上发现,研究团队的目标从「解释现象」转向了「主动创造」。他们通过系统的实验,最终调配出了一套最优的数据混合方案,旨在平衡模型的语言能力和视觉潜力。

实验结果表明,通过采用这种富含推理内容、同时配有适量视觉世界知识的「平衡配方」(Balanced model),训练出的 7B 模型在语言能力上与专门优化语言任务的预训配方训练的模型达到了更优,同时在所有视觉基准测试中都实现了全面超越。

这证明了,通过精心设计文本预训练数据,我们可以「未卜先知」地为模型注入强大的视觉先验。

意义与展望

这项研究的意义深远,它将多模态模型能力的培养,从依赖下游微调提前到了语言预训练阶段。

它展示了,核心的推理能力是一种可迁移、与模态无关的基石。这为「柏拉图表征假说」(Platonic Representation Hypothesis)提供了有力的经验支持 —— 即文本和图像只是现实世界在不同模态下的「投影」,一个足够强大的模型可以仅从一种投影中,学习到这个世界的统一内在结构。

未来,LLM 的预训练将不再仅仅是单模态的事。模型设计者从一开始就可以考虑其未来的多模态应用,通过在预训练阶段「播下视觉的种子」,来构建一个更强大的跨模态智能基础。

更多技术细节和实验分析,请参阅原论文。

作者介绍

韩俊霖(Junlin Han)是这篇论文的第一作者兼项目负责人。他目前是 Meta 超级智能实验室的研究员,同时也是牛津大学 Torr Vision Group 的博士生,师从 Philip Torr 教授。他的研究兴趣聚焦多模态智能系统,先后在跨模态数据生成、3D 生成模型等领域开展研究。此前,他以一等荣誉毕业于澳大利亚国立大学,曾在顶级会议多次发表重要研究成果并组织研讨会。

文章第二作者 Peter Tong(童晟邦 / Shengbang Tong),目前是纽约大学 Courant 计算机科学系的博士生,导师包括 Yann LeCun 和 Saining Xie。他曾在伯克利人工智能实验室 (BAIR) 进行本科研究,师从马毅教授。研究方向包括世界模型 (world model)、无监督 / 自监督学习、生成模型与多模态模型。他曾获得了 OpenAI Superalignment Fellowship 和 Meta 的博士项目资助。

第三作者 David Fan现任 Meta FAIR 的高级研究工程师。他的研究方向集中在多模态表征学习、视频理解 / 自监督学习等领域。 在加入 FAIR 之前,他曾在 Amazon Prime Video 担任 Applied Research Scientist,参与视觉 - 语言 - 音频融合模型、视频理解和推荐系统等真实产品项目。他于普林斯顿大学获得计算机科学学位。

(责任编辑:时尚)

-

来源:环球网10月11日,在2025中国移动全球合作伙伴大会上,“移动爱购”数智生活商城上线试运营。作为中国移动数智化战略的重要落地成果,“移动爱购”商城面向超10亿用户,以“连接+应用+权益+硬件”

...[详细]

来源:环球网10月11日,在2025中国移动全球合作伙伴大会上,“移动爱购”数智生活商城上线试运营。作为中国移动数智化战略的重要落地成果,“移动爱购”商城面向超10亿用户,以“连接+应用+权益+硬件”

...[详细]

-

因经历过稽留流产,近日28岁、孕17周的张女士化名)来到长沙市妇幼保健院遗传科要求进行羊水穿刺检查。原本只为求个安心,却未料到这份报告给出了一个惊人的结果:胎儿7条染色体惊现大片纯合区域ROH),

...[详细]

因经历过稽留流产,近日28岁、孕17周的张女士化名)来到长沙市妇幼保健院遗传科要求进行羊水穿刺检查。原本只为求个安心,却未料到这份报告给出了一个惊人的结果:胎儿7条染色体惊现大片纯合区域ROH),

...[详细]

-

版权声明:本文版权为网易汽车所有,转载请注明出处。网易汽车8月19日报道在充满活力与激情的夏日,由福特中国主办的“2025福特优行创新挑战赛”全国总决赛于上海成功落下帷幕。本次大赛吸引了近3,000名

...[详细]

版权声明:本文版权为网易汽车所有,转载请注明出处。网易汽车8月19日报道在充满活力与激情的夏日,由福特中国主办的“2025福特优行创新挑战赛”全国总决赛于上海成功落下帷幕。本次大赛吸引了近3,000名

...[详细]

-

8月19日上午,沪深两市成交额连续第59个交易日破万亿元,较昨日此时放量约59.28亿元。 相关新闻 中金:A股当前整体估值处于合理区间 并未高估证券时报) 人民财讯8月19日电,中金公司研

...[详细]

8月19日上午,沪深两市成交额连续第59个交易日破万亿元,较昨日此时放量约59.28亿元。 相关新闻 中金:A股当前整体估值处于合理区间 并未高估证券时报) 人民财讯8月19日电,中金公司研

...[详细]

-

保质期12个月的“真空玉米” 营养成分还“在线”吗?2025-10-14 07:59:07 来源:扬子晚报

...[详细]

保质期12个月的“真空玉米” 营养成分还“在线”吗?2025-10-14 07:59:07 来源:扬子晚报

...[详细]

-

近年来,全球政经格局深度调整下的中东地区正以其巨大经济潜力倍受关注。作为区域发展“双引擎”,沙特阿拉伯与阿联酋不仅拥有独特地理优势和雄厚经济实力,同时沙特“2030愿景”与阿联酋“2071百年计划”与

...[详细]

近年来,全球政经格局深度调整下的中东地区正以其巨大经济潜力倍受关注。作为区域发展“双引擎”,沙特阿拉伯与阿联酋不仅拥有独特地理优势和雄厚经济实力,同时沙特“2030愿景”与阿联酋“2071百年计划”与

...[详细]

-

△加沙地带资料图) 当地时间16日晚间,针对可能重启的加沙停火谈判,以色列总理办公室发表声明。 声明指出,以色列同意达成协议的前提,是必须一次性释放所有以色列被扣押人员,并且协议必须符合以色列结束

...[详细]

△加沙地带资料图) 当地时间16日晚间,针对可能重启的加沙停火谈判,以色列总理办公室发表声明。 声明指出,以色列同意达成协议的前提,是必须一次性释放所有以色列被扣押人员,并且协议必须符合以色列结束

...[详细]

-

当地时间8月19日,据消息人士透露,美国司法部正在调查华盛顿特区大都会警察局是否操纵了犯罪数据。 当地时间8月18日,特朗普在社交媒体上发文称“华盛顿特区提供虚假的犯罪数据是为了制造一种虚假的安

...[详细]

当地时间8月19日,据消息人士透露,美国司法部正在调查华盛顿特区大都会警察局是否操纵了犯罪数据。 当地时间8月18日,特朗普在社交媒体上发文称“华盛顿特区提供虚假的犯罪数据是为了制造一种虚假的安

...[详细]

-

据中央纪委国家监委驻中国证监会纪检监察组、浙江省纪委监委消息:中国证监会原发行审核委员会主任委员、发行监管部副主任、一级巡视员郭旭东涉嫌严重职务违法,主动投案,目前正接受中央纪委国家监委驻中国证监

...[详细]

据中央纪委国家监委驻中国证监会纪检监察组、浙江省纪委监委消息:中国证监会原发行审核委员会主任委员、发行监管部副主任、一级巡视员郭旭东涉嫌严重职务违法,主动投案,目前正接受中央纪委国家监委驻中国证监

...[详细]

-

每天睡够8小时还是困?上班没力气,下班不想动,周末补觉也缓不过来……这种“累”可能不是简单的疲劳,而是身体发出的健康警报。AI生成图有些“累”不是简单的疲劳持续时间较长的疲劳感,让人感到身心俱疲,无论

...[详细]

每天睡够8小时还是困?上班没力气,下班不想动,周末补觉也缓不过来……这种“累”可能不是简单的疲劳,而是身体发出的健康警报。AI生成图有些“累”不是简单的疲劳持续时间较长的疲劳感,让人感到身心俱疲,无论

...[详细]

琼州海峡客滚船将于18日10时起复运

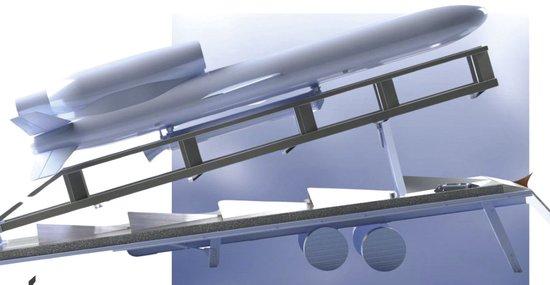

琼州海峡客滚船将于18日10时起复运 “火烈鸟”亮相,乌克兰量产3000公里巡航导弹

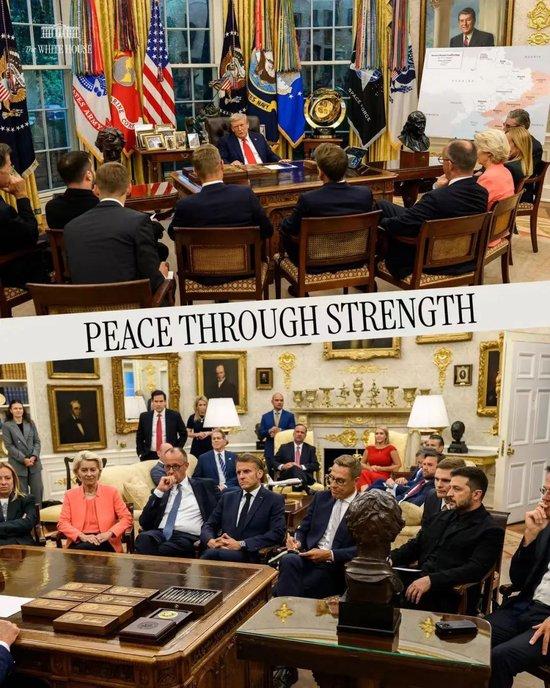

“火烈鸟”亮相,乌克兰量产3000公里巡航导弹 这是白宫里前所未见的一幕

这是白宫里前所未见的一幕 vivo AI战略再升级:成为连接物理世界与数字世界的桥梁

vivo AI战略再升级:成为连接物理世界与数字世界的桥梁